GPU-ul T4 de laNvidia va aparea in produsele Google si castiga suport de la Cisco, Dell EMC, Fujitsu, HPE, IBM, Oracle si SuperMicro.

Nvidia isi dezvolta departamentul responsabil pentru centrele de date, extinzandu-si acoperirea pe diferite tipuri de AI cu ajutorul GPU-ul Tesla T4, pe baza noii arhitecturi Turing.

GPU-ul T4 este componenta esentiala a noii platforme TensorRT Hyperscale Inference, un card accelerator de mici dimensiuni, care se asteapta sa fie folosit de principalii producatori de servere incepand cu trimestrul al patrulea.

Modelul T4 include Turing Tensor Cores, care suporta diferite nivele de precizie de calcul pentru diferite aplicatii AI precum si framework-uri de software – TensorFlow, PyTorch, MXNet, Chainer si Caffe2 – pentru asa-numitul deep learning.

“Tesla T4 se bazeaza pe arhitectura Turing, care cred ca va revolutiona modul in care un AI este implementat in centrele de date”, a declarat CEO-ul Nvidia, Jensen Huang, in timp ce prezenta noul GPU la evenimentul companiei GTC din Tokyo. “GPU-ul Tensor Core este o reinventare a GPU-ului nostru – am decis sa reinventam GPU-ul in totalitate.”

Arhitectura paralela masiva a GPU-urilor le face potrivite pentru AI. Capabilitatile de paralel-computing ale GPU-urilor Nvidia sunt asociate cu o putere de procesare mare, o combinatie ce le va mentine tehnologia standard pentru un AI timp de cativa ani.

Prelucrarea cu precizie multipla este un avantaj pentru AI

Marele pas inainte pentru GPU-urile T4 si noua platforma de inferenta este abilitatea de a face procesari cu o precizie mult mai mare fata de GPU-urile anterioare P4 bazate pe arhitectura Pascal.

Odata ce modelele de retele neuronale sunt instruite pe seturi masive de date, acestea sunt implementate in aplicatii pentru inferente – clasificarea datelor pentru a “deduce” un rezultat. In timp ce antrenamentul reprezinta doar calcul intensiv, inferentele in aplicatiile desfasurate in lumea reala necesita cat mai multa flexibilitate posibila.

In mod ideal, fiecare nivel al unei retele neuronale trebuie procesat cu cea mai mica precizie necesara pentru acel strat, pentru asigura o procesare rapida si eficienta energetic.

“Prin crearea unei arhitecturi care sa poata amesteca toate aceste precizii mixte, putem maximiza acuratetea si performanta, toate la doar 75 de wati”, a spus Huang, adaugand ca T4-urile sunt de cel putin opt ori mai rapide decat P4-urile si, in unele cazuri, de 40 chiar de ori mai repide.

Nevoia de aceasta tehnologie creste rapid, dat fiind ca centrele de date au pus in productie o mare varietate de aplicatii care manipuleaza miliarde de interogari vocale, traduceri, imagini si videoclipuri, recomandari si interactiuni social-media. Nvidia estimeaza ca industria AI este pe cale sa creasca in urmatorii cinci ani si va ajunge la o valoare de 20 de miliarde de dolari. Aplicatii diferite necesita niveluri de procesare diferite.

“Nu doriti sa efectuati calcule pe 32 de biti daca aplicatiile necesita 16 biti”, a declarat Patrick Moorhead, fondatorul firmei Moor Insights & Strategy. “Nvidia a stabilit noul standard pentru tehnologia folosita in centrele de date pentru AI.”

Ce este platforma Hyperscale TensorRT?

Componentele platformei TensorRT Hyperecale sunt:

• GPU-ul Nvidia Tesla T4, care contine 320 nuclee Turing si 2.560 nuclee CUDA (Compute Unitified Device Architecture). CUDA este limbajul de programare folosit Nvidiei pentru procesarea paralela. Capabilitatile de procesare multipla ale T4-ului includ FP16 (aritmetica cu virgula mobila pe 16 biti) pana la FP32, INT8 (aritmetica integrata pe 8 biti) si INT16. T4 este capabil de 65 teraflops la cea mai buna performanta pentru FP16, 130 teraflops pentru INT8 si 260 teraflops pentru INT4.

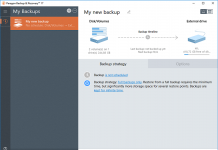

• TensorRT 5, un optimizator de inferente si de timp de executie pentru invatarea profunda. Este proiectat pentru inferente cu latenta redusa, cu o performanta ridicata, pentru optimizarea, validarea rapida si implementarea retelelor neuronale instruite pentru inferenta in centrele de date hyperscale, platformele GPU incorporate sau auotomotive. Sunt optimizate pentru TensorFlow, MXNet, Caffe2 si Matlab si alte framework-uri prin intermediul ONNX (Open Neural Network Exchange).

• Serverul TensorRT, pe care Nvidia il ofera ca server de deducere pentru implementarea unui data center. Este conceput pentru a scala atat instruirea, cat si procesarea inferentelor la grupurile GPU multicoure si se integreaza cu Kubernetes si Docker, permitand dezvoltatorilor sa automatizeze procesarea, programarea si operarea mai multor containere de aplicatii GPU.

Suportul software este esential pentru GPU-ul T4

“Continuam sa investim si sa optimizam intregul nostru pachet de software si facem acest lucru prin valorificarea framework-urilor disponibile, astfel incat toata lumea sa-si poata rula retelele neuronice cat de curand posibil – pot sa-si ia modelele de antrenament si sa le implementeze chiar in acea zi “, a declarat Ian Buck, vicepresedinte al Accelerated Computing business unit Nvidia.

In domeniul AI, Nvidia a vazut concurenta din partea producatorilor de FPGA, in special Xilinx. Programabilitatea FPGA permite dezvoltatorilor sa ajusteze precizia calculului utilizat in functia de nevoia nivelului retelei neuronale. Totusi FPGA-urile au o curba abrupta de invatare pentru programatori. Modificarile FPGA a fost facuta de-a lungul anilor cu ajutorul limbajelor HDL (Hardware Description Languages) si deci nu cu ajutorul limbajelor de nivel superior utilizate pentru alte chipuri.

FPGA-uri, competitive pentru GPU-uri

FPGA-urile ofera concurenta pentru GPU-uri.

In luna martie, Xilinx a dezvaluit ceea ce numeste o noua categorie de produse – platforma Adaptive Compute Acceleration Platform (ACAP) – care va avea mai mult suport software decat FPGA-urile traditionale. Prima versiune ACAP, numita Everest, urmeaza sa fie livrata anul viitor, iar Xilinx spune ca dezvoltatorii de software vor putea sa lucreze cu Everest folosind limbaje de programare ca C / C ++, OpenCL si Python. Everest poate fi, de asemenea, programat la nivel hardware, registru-transfer (RTL) folosind instrumente HDL precum Verilog si VHDL.

Totusi, suportul software oferit de GPU-urile T4, impreuna cu capabilitatile sale de multiprecise, par a fi destinate sa fortifice pozitia companiei Nvidia atat in formarea AI cat si in inferente.

“Credem ca avem cea mai eficienta platforma de inferente”, a spus Buck, ” lucram cu toti clientii la stack-ul nostru pentru a va asigura ca nu oferim doar cea mai buna pregatire, dar acum si cea mai buna platforma de inferente. ”

Practic toti producatorii de servere care folosesc GPU-urile P4 vor trece la T4 pana la sfarsitul anului, a spus Buck. La evenimentul din Tokyo, suportul pentru T4 a fost exprimat de producatorii de centre de date precum Cisco, Dell EMC, Fujitsu, HPE, IBM, Oracle si SuperMicro.

In plus, Google a declarat ca va folosi noile T4-uri.

[…] majori de data centere din America de Nord au suficienta memorie pentru urmatoarele cinci pana la sase saptamani, in timp […]