Astazi a avut loc o dezvaluire coordonata a noilor rezultate MLPerf v0.5. MLPerf v0.5 este incercarea industriei de a crea un benchmark de tip “SPEC”de performanta pentru industrie, pentru a arata diferentele dintre mai multe arhitecturi ale masinilor de invatat. Intregul spatiu se schimba atat de repede incat a fost dificil sa se obtina un efort coordonat in comparatiile performantelor. In prezent exista trei echipe care colecteaza rezultate. Intamplator, acestea sunt companii care au mari echipe de software engineering: NVIDIA, Intel si Google. In ciuda concurentei aparute, NVIDIA este inca liderul in hardware-ul de formare in domeniul deep learning, si si-a propus sa demonstreze acest aspect prin rezultatele MLPerf.

Prezentare MLPerf v0.5

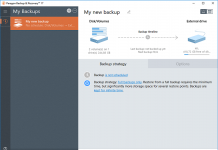

Framework-urile masinilor de invatare se schimba in timp, deci alegerea unor criterii relevante este o sarcina dificila. STH va adopta MLPerf in ianuarie 2019 si este deja folosit pe sistemele cu 8x GPU in anumite laboratoare.

Ca si precizare, reteaua de invatare de back-up Mini-Go, de la NVIDIA, nu s-a folosit. La apelul dinantea briefing-ului, NVIDIA a afirmat ca este o retea care favorizeaza procesoarele. Un sistem dual Intel Xeon Platinum 8180 a dezvoltat o accelerare de 6,6 ori peste concurenta NVIDIA cu Tesla P100, astfel incat NVIDIA nu a crezut ca ar putea sa bata Intel la acest capitol. Acest lucru este interesant doar pentru ca Intel lauda capabilitatile de invatare profunda a chipului sau de server Cooper Lake bfloat16 de urmatoarea generatie, care trebuie sa apara in curand. Chipul Cooper Lake, ar trebui sa depaseasca chipul actual Platinium 8180 cu o marja substantiala.

NVIDIA stabileste recorduri in MLPerf cu DGX-2H

Ceea ce este cu adevarat interesant este ca NVIDIA foloseste platforma sa, DGX-2H. Aceasta este o platforma de 16x NVIDIA Tesla V100 care este o actualizare a DGX-2.De asemenea, stim ca DGX-2H utilizeaza o limita TDP de 450W pe modulele Tesla V100 32GB . Aceasta ofera DGX-2H o cifra maxima de consum de putere uimitoare de 12 kW.

NVIDIA DGX-2H a fost mentionata recent, la Supercomputing 2018. Nota de subsol a diapozitivelor NVIDIA indica initial un alt procesor, Intel Xeon Platinum 8189 SKU, insa NVIDIA a corectat specificatiile sistemului de testare, care enumera acum SKU-ul Platinum 8174 in DGX-2H asa cum a fost raportat anterior. De asemenea, stim ca DGX-2H utilizeaza o limita TDP de 450W pe modulele Tesla V100 32GB . Aceasta ofera DGX-2H o cifra maxima de consum de putere de 12 kW.

Rezultatele MLPERF:

Clasificare imagini RN50 v.1.5 – 6.3 minute

Detectare obiecte Mask R-CNN – 72.1 minute

Detectare obiecte simple SSD 5.6 minute

Traducere recurenta GNMT 2.7 minute

Traducere non-recurenta 6.2 minute

NVIDIA foloseste un cluster DGX-2 pentru primele trei teste. Pentru ultimele doua teste, utilizeaza un cluster DGX-1V Saturn de la supercomputerul intern din Top500 al companiei. Este utilizata aceeasi configuratie DGX-2H cu procesor dual Intel Xeon Platinum 8174.

In general, operatiunile sunt foarte rapide. In cadrul testului de clasificare a imaginilor, Google are un cluster TPUv3.512 + TPUv2.8 de 260 de cipuri, care era putin mai rapid decat sistemele NVIDIA DGX-2H, dar mai lent decat sistemele DGX-1 80x. Sistemene DGX-2 32 x (standard) sunt listate la aproximativ 400.000 de dolari, fiecare facand cluster ajungand la un pret mai mare de 12.8 milioane de dolari.